一、ollama是什么?

Ollama 是一个专注于本地部署和运行大语言模型(LLM)的开源工具,由美国公司 Ollama Inc. 开发。它提供了简单的命令行界面和 HTTP API,使开发者能够在本地环境快速部署、运行和交互各种开源 LLM,无需依赖云服务。

-

自己对ollama的理解

ollama是一个开源的LLM的工具,管理市面上现有的大模型,通过ollama可以快速部署本地大模型,如deepseek、qwen等,类似于docker拉取容器一样的关系一样

-

核心功能

- 模型库与一键部署

- LLM管理

- 优化推理

- Http Api和工具连接

二、安装ollama

-

官网下载

官网地址:https://ollama.com

点击下载,按照提示直接安装即可

-

命令安装

-

macOS

brew install ollama -

linux

curl -s https://ollama.com/install | bash -

Windows

用户可以通过 WSL2 安装

-

-

docker镜像

docker run -d --gpus=all \ -e OLLAMA_KEEP_ALIVE=-1 \ -e OLLAMA_NUM_PARALLEL=4 \ -e OLLAMA_FLASH_ATTENTION=1 \ -v /data3/alex/ollama:/root/.ollama \ -p 23153:11434 --name ollama-vincent docker.io/ollama/ollama:0.3.11

三、验证

ollama -v

出现版本号说明安装成功

四、拉取模型

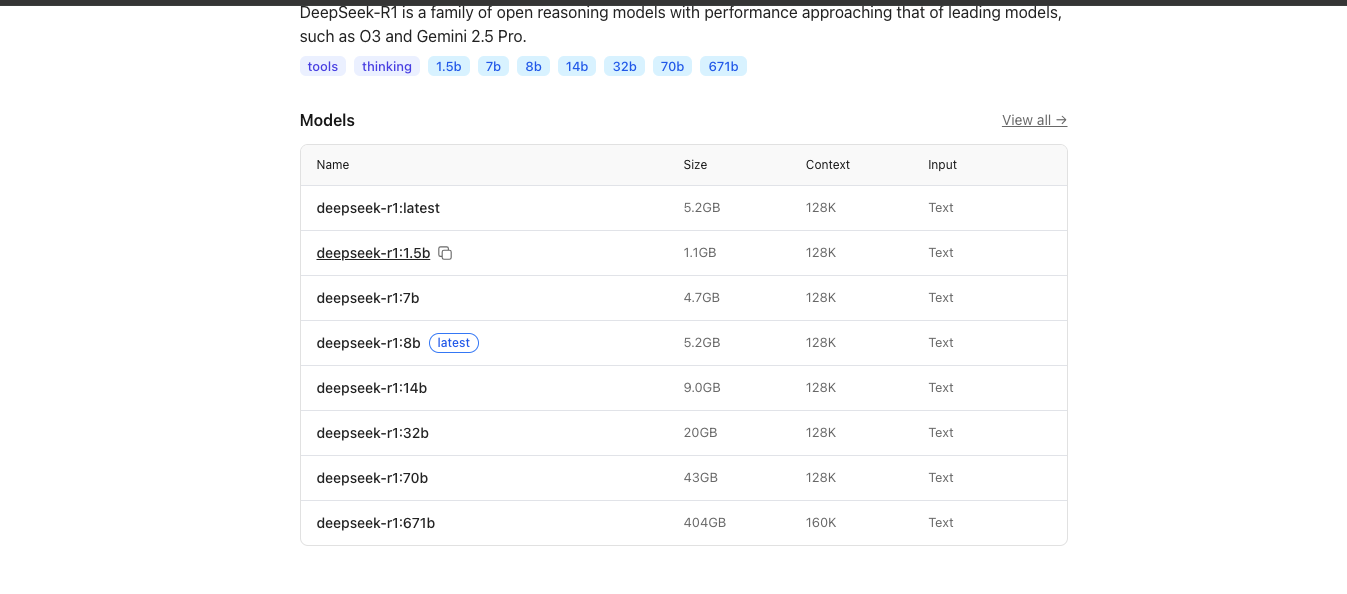

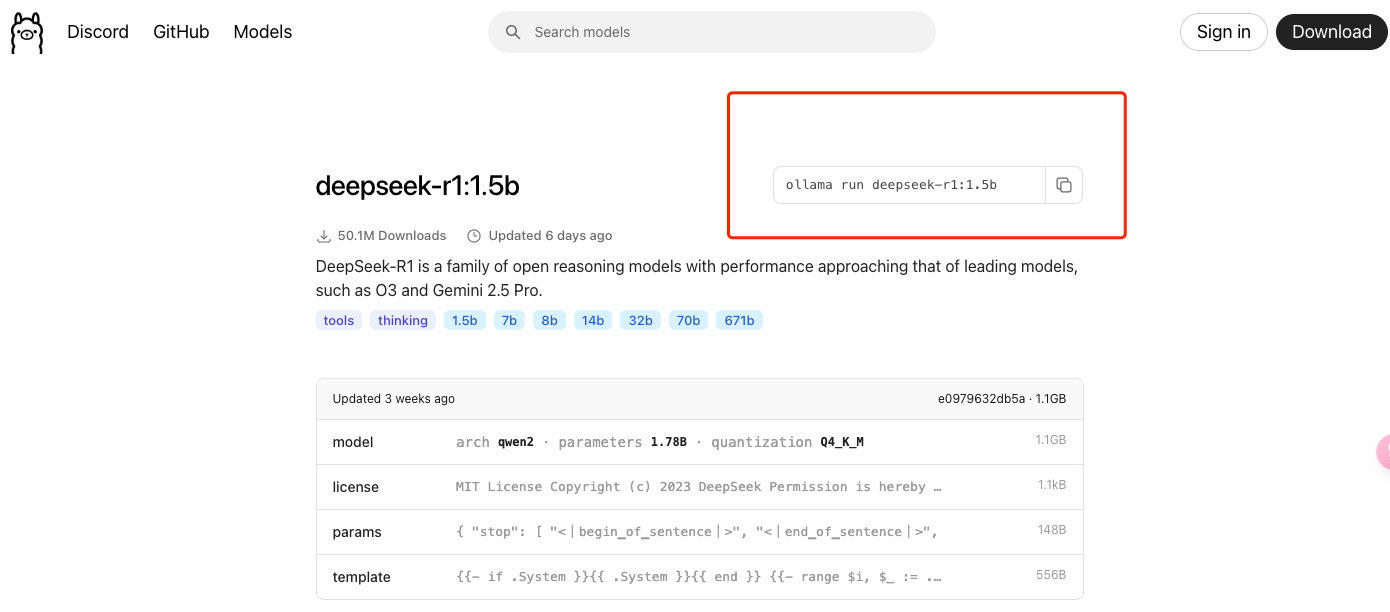

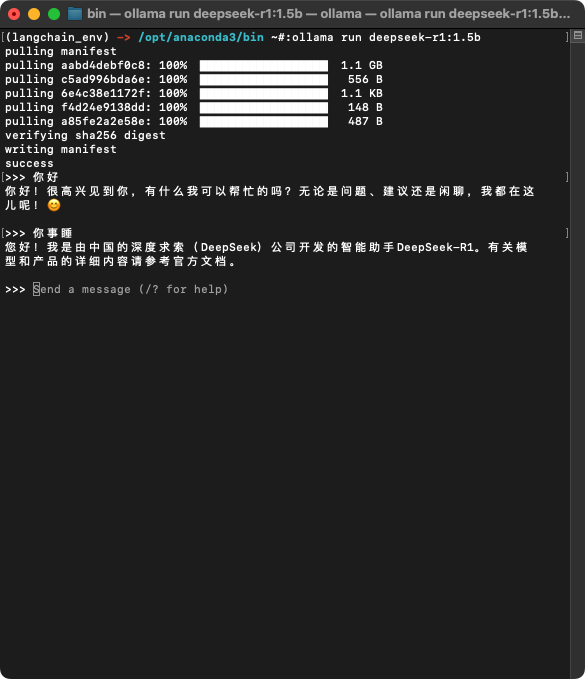

以拉取deepseek-r1:1.5b为例

在官网点击搜索,会有提示

选择deepseek-r1

点击进去复制命令、执行

四、验证模型是否拉取成功

拉取成功会跟模型对话,这个时候可以做简单的对话

用命令查看模型

ollama list

五、ollama常用命令

-

拉取模型 (pull)

ollama pull 模型名称 -

列出本地模型 (list)

ollama list -

删除本地模型

ollama rm 模型名称 -

拷贝模型

ollama cp 模型名称 自定义模型名称 -

将提示作为参数传递

ollama run 模型名称 "Summarize this file: $(cat README.md)" -

显示模型信息

ollama show 模型名称 -

列出当前加载的模型

ollama ps -

停止当前正在运行的模型

ollama stop 模型名称 -

启动 Ollama

当您想在不运行桌面应用程序的情况下启动 OLLAMA 时使用

ollama serve

github:https://github.com/ollama/ollama

五、Rest API

-

Generate a response 生成响应

curl http://localhost:11434/api/generate -d '{ "model": "llama3.2", "prompt":"Why is the sky blue?" }' -

Chat with a model 与模型聊天

curl http://localhost:11434/api/chat -d '{ "model": "llama3.2", "messages": [ { "role": "user", "content": "why is the sky blue?" } ] }'