背景

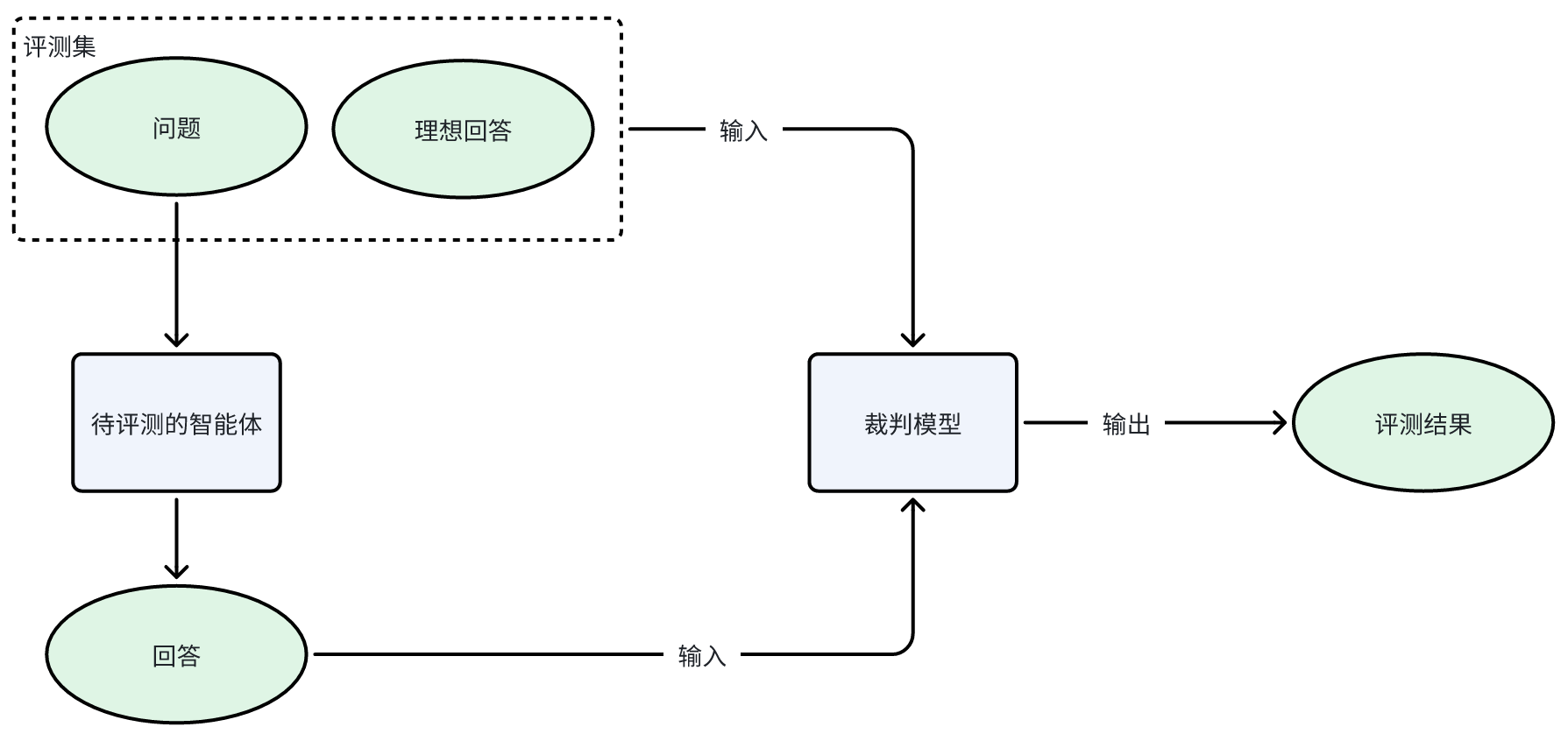

裁判模型是专用于评估智能体输出质量的辅助模型,该模型在评测中充当裁判员的角色,对评测对象输出的生成结果进行质量评估,并根据评测规则对每一条回复进行打分。裁判模型也可以评测主观问题和开放性问题,只需要用户 Query 和模型回复,即可自动对评测对象的表现进行质量评估与评价,无需人工标注,流程高度自动化,可大幅提高评测效率。

选择模型打分时,需要指定明确、详细、清晰的评分标准。

实践

先用代码驱动编写测试脚本, 以下以Coze为例

private static readonly HttpClient _httpClient = new HttpClient();

private static readonly SemaphoreSlim _logSemaphore = new SemaphoreSlim(1, 1);

private const string ApiUrl = “https://api.coze.cn/open_api/v1/web_chat?msToken=”;static async Task Main(string[] args)

{

// 配置HttpClient

_httpClient.DefaultRequestHeaders.Accept.Add(

new MediaTypeWithQualityHeaderValue(“text/event-stream”));

_httpClient.Timeout = TimeSpan.FromMinutes(30);

Parallel.ForEach(ChatQuery.largeModelTestQuestions.Concat(ChatQuery.advancedModelTestQuestions),

new ParallelOptions { MaxDegreeOfParallelism = 20 },

async (question, token) =>

{

await ChatWithCozeApi(question);

});Console.ReadLine();

}private static async Task SendSSERequest(object requestBody)

{

var json = JsonSerializer.Serialize(requestBody);

using var content = new StringContent(json, Encoding.UTF8, “application/json”);try

{

// 修复参数问题:正确使用 HttpCompletionOption

using var response = await _httpClient.PostAsync(

ApiUrl,

content

); // 移除了额外的参数response.EnsureSuccessStatusCode();

var finalRespResult = await response.Content.ReadAsStringAsync();

Console.WriteLine(finalRespResult);

await _logSemaphore.WaitAsync();

try

{

await File.AppendAllTextAsync(“coze_api_log.txt”, $”{DateTime.Now}: {finalRespResult}{Environment.NewLine}”);

}

finally

{

_logSemaphore.Release();

}

}

catch (Exception ex)

{

Console.WriteLine($”请求失败: {ex.Message}”);

await _logSemaphore.WaitAsync();

try

{

await File.AppendAllTextAsync(“coze_api_log-ERROR.txt”, $”{DateTime.Now}: Request failed: {ex.Message}{Environment.NewLine}”);

}

finally

{

_logSemaphore.Release();

}

}

}

运行结果集

data:{“messages”:[{“role”:”user”,”type”:”ack”,”content”:”用户:帮我制定一个学习Python的计划。 助手:(给出初步计划) 用户:我觉得第一周的内容太简单了,可以调整一下吗?”,”content_type”:”text”,”reasoning_content”:””},{“role”:”assistant”,”type”:”answer”,”content”:”\n\n我会为您优化Python学习计划,强化核心知识点和实践强度:\n\n调整后28天学习路线:\n\n【第一阶段:核心语法速通】(5天)\nDay1-2:语法精要\n- 掌握变量作用域(全局/局部/nonlocal)\n- 深入理解可变对象与不可变对象\n- 列表推导式与生成器表达式\n- 异常处理机制(try/except/finally)\n\nDay3-4:函数编程\n- 参数传递机制(*args, **kwargs)\n- lambda表达式与高阶函数\n- 闭包与装饰器原理\n- 函数式编程工具(map/filter/reduce)\n\nDay5:实战小项目\n- 开发汇率转换器(带实时API调用)\n- 实现命令行版2048游戏\n\n【第二阶段:面向对象与模块化】(7天)\nDay6-8:OOP进阶\n- 魔法方法(__init__, __str__等)\n- 多重继承与MRO机制\n- 抽象基类与接口设计\n- 元类编程基础\n\nDay9-10:标准库深度使用\n- collections模块高级用法\n- itertools迭代器组合\n- concurrent.futures并发编程\n- asyncio异步编程基础\n\nDay11-12:项目实战\n- 开发Markdown转换工具\n- 实现简易Web爬虫框架\n\n【第三阶段:全栈项目开发】(16天)\nDay13-16:Web开发基础\n- FastAPI框架深度使用\n- ORM(SQLAlchemy)进阶\n- RESTful API设计与JWT认证\n\nDay17-20:数据科学实战\n- Pandas高级数据操作\n- Matplotlib/Seaborn可视化\n- Scikit-learn机器学习流程\n- 开发用户行为分析系统\n\nDay21-28:综合项目开发\n- 全栈电商平台开发(前后端分离)\n- 实现自动化交易策略回测系统\n- 开发个人知识管理系统(含OCR识别)\n\n学习建议:\n1. 每天配套LeetCode中级题练习\n2. 参与GitHub开源项目贡献\n3. 定期进行代码重构练习\n4. 关注Python3.10+新特性(模式匹配、类型联合运算符)\n\n学习资源推荐:\n- RealPython高级教程\n- Fluent Python(第二版)\n- Python官方PEP文档\n- 哈佛CS50’s Web Programming课程\n\n这个计划强调深度理解和项目实践,可根据您的实际进度动态调整各阶段时长。建议每周进行一次代码审查,保持持续迭代优化。需要具体某个方向的详细规划可以随时告诉我。”,”content_type”:”text”,”reasoning_content”:””},{“role”:”assistant”,”type”:”verbose”,”content”:”{\”msg_type\”:\”generate_answer_finish\”,\”data\”:\”\”,\”from_module\”:null,\”from_unit\”:null}”,”content_type”:”text”,”reasoning_content”:””},{“role”:”assistant”,”type”:”verbose”,”content”:”{\”msg_type\”:\”generate_answer_finish\”,\”data\”:\”{\\\”finish_reason\\\”:0,\\\”FinData\\\”:\\\”\\\”}\”,\”from_module\”:null,\”from_unit\”:null}”,”content_type”:”text”,”reasoning_content”:””}],”conversation_id”:”agMS7VGk4nXyWU_agXqpU”,”code”:0,”msg”:”success”}

评测提示词

您是LLM测试专家,LLM模型打分规则如下

裁判模型是专用于评估智能体输出质量的辅助模型,该模型在评测中充当裁判员的角色,对评测对象输出的生成结果进行质量评估,并根据评测规则对每一条回复进行打分。裁判模型也可以评测主观问题和开放性问题,只需要用户 Query 和模型回复,即可自动对评测对象的表现进行质量评估与评价,无需人工标注,流程高度自动化,可大幅提高评测效率。

选择模型打分时,需要指定明确、详细、清晰的评分标准。请对如下对话生成结果评分

{

Question:

帮我制定一个学习Python的计划。 助手:(给出初步计划) 用户:我觉得第一周的内容太简单了,可以调整一下吗?Answer:

我会为您优化Python学习计划,强化核心知识点和实践强度:

调整后28天学习路线:

【第一阶段:核心语法速通】(5天)

Day1-2:语法精要掌握变量作用域(全局/局部/nonlocal)

深入理解可变对象与不可变对象

列表推导式与生成器表达式

异常处理机制(try/except/finally)

Day3-4:函数编程参数传递机制(*args, **kwargs)

lambda表达式与高阶函数

闭包与装饰器原理

函数式编程工具(map/filter/reduce)

Day5:实战小项目开发汇率转换器(带实时API调用)

实现命令行版2048游戏

【第二阶段:面向对象与模块化】(7天)

Day6-8:OOP进阶魔法方法(init, __str__等)

多重继承与MRO机制

抽象基类与接口设计

元类编程基础

Day9-10:标准库深度使用collections模块高级用法

itertools迭代器组合

concurrent.futures并发编程

asyncio异步编程基础

Day11-12:项目实战开发Markdown转换工具

实现简易Web爬虫框架

【第三阶段:全栈项目开发】(16天)

Day13-16:Web开发基础FastAPI框架深度使用

ORM(SQLAlchemy)进阶

RESTful API设计与JWT认证

Day17-20:数据科学实战Pandas高级数据操作

Matplotlib/Seaborn可视化

Scikit-learn机器学习流程

开发用户行为分析系统

Day21-28:综合项目开发全栈电商平台开发(前后端分离)

实现自动化交易策略回测系统

开发个人知识管理系统(含OCR识别)

学习建议:每天配套LeetCode中级题练习

参与GitHub开源项目贡献

定期进行代码重构练习

关注Python3.10+新特性(模式匹配、类型联合运算符)

学习资源推荐:RealPython高级教程

Fluent Python(第二版)

Python官方PEP文档

哈佛CS50’s Web Programming课程

这个计划强调深度理解和项目实践,可根据您的实际进度动态调整各阶段时长。建议每周进行一次代码审查,保持持续迭代优化。需要具体某个方向的详细规划可以随时告诉我。}

在QWen3-232B-A22B下评估

结论

基于大模型SSE(Server-Sent Events)的HTTP API接口测试与评估具有多层次的意义,尤其在实时性、智能化服务场景中,其价值体现在技术可靠性、业务效能和用户体验优化等多个维度:

一、技术层面:保障系统稳定性与性能边界

-

实时性验证

- SSE的核心优势是单向实时推送,测试需验证长连接稳定性、消息延迟(如端到端延迟是否≤500ms)、断线重连机制,确保大模型生成的实时数据(如对话流、动态分析)能无缝传输。

- 评估指标:连接建立时间、消息到达率、重连成功率。

-

大模型负载下的接口韧性

- 大模型推理可能伴随高并发请求(如千级QPS),需测试API在模型推理延迟波动、突发流量下的吞吐量(如能否稳定处理峰值请求)及资源利用率(CPU/内存/GPU是否过载)。

- 典型场景:模拟多用户同时发起复杂查询(如长文本生成),观察接口是否出现阻塞或响应降级。

-

数据一致性校验

- 验证SSE流式传输中数据分片的完整性(如避免消息截断、乱序),尤其是大模型分步生成内容时(如逐句输出),需确保客户端接收到的数据与模型最终输出完全一致。

二、业务层面:驱动服务效能与成本控制

-

成本优化依据

- 通过压力测试定位性能瓶颈(如模型推理耗时占API总响应时间的80%),可针对性优化(如模型量化、缓存热点查询),降低单次请求的GPU计算成本。

- 评估不同并发量下的成本效率曲线,为资源扩容(如Kubernetes自动伸缩)提供数据支撑。

-

服务可靠性量化

- 定义SLA(服务等级协议)指标(如99.9%的请求需在1秒内响应),通过混沌工程测试(如模拟网络抖动、模型服务宕机)验证系统容错能力,减少业务中断风险。

-

合规与安全性验证

- 测试API对敏感数据的处理(如用户输入脱敏、模型输出过滤),评估是否符合GDPR等法规要求。

- 验证鉴权机制(如JWT令牌)能否抵御重放攻击、越权访问等威胁。

三、用户体验层面:构建实时智能交互基石

-

流畅度与交互延迟感知

- 用户对实时对话的容忍延迟通常≤300ms,需通过全链路监控(从用户输入到SSE推送)优化关键路径,避免因接口延迟导致对话卡顿或中断。

-

异常场景的容错设计

- 模拟模型超时、服务降级等场景,测试API是否能返回友好提示(如“生成中,请稍候”)而非直接报错,提升用户留存率。

-

多客户端兼容性

- 验证SSE在不同客户端(浏览器、移动端)的兼容性(如EventSource API支持情况),确保跨平台体验一致性。

四、持续迭代与模型进化闭环

-

A/B测试支撑

- 通过API监控数据(如响应时间分布、错误类型统计),对比不同模型版本(如Llama 3.1 vs. Gemini)在真实流量下的表现,为模型选型提供客观依据。

-

反馈驱动优化

- 将API日志(如高频错误请求、超时案例)反哺给模型训练团队,针对性优化长尾查询效果,形成“测试-反馈-优化”的闭环。

基于大模型SSE的HTTP API测试与评估,本质是构建实时智能服务的可信底座。它不仅关乎技术指标的达标,更直接影响业务成本、用户留存和模型迭代效率。

今天先到这儿,希望对云原生,技术领导力, 企业管理,系统架构设计与评估,团队管理, 项目管理, 产品管理,信息安全,团队建设 有参考作用 , 您可能感兴趣的文章:

构建创业公司突击小团队

国际化环境下系统架构演化

微服务架构设计

视频直播平台的系统架构演化

微服务与Docker介绍

Docker与CI持续集成/CD

互联网电商购物车架构演变案例

互联网业务场景下消息队列架构

互联网高效研发团队管理演进之一

消息系统架构设计演进

互联网电商搜索架构演化之一

企业信息化与软件工程的迷思

企业项目化管理介绍

软件项目成功之要素

人际沟通风格介绍一

精益IT组织与分享式领导

学习型组织与企业

企业创新文化与等级观念

组织目标与个人目标

初创公司人才招聘与管理

人才公司环境与企业文化

企业文化、团队文化与知识共享

高效能的团队建设

项目管理沟通计划

构建高效的研发与自动化运维

某大型电商云平台实践

互联网数据库架构设计思路

IT基础架构规划方案一(网络系统规划)

餐饮行业解决方案之客户分析流程

餐饮行业解决方案之采购战略制定与实施流程

餐饮行业解决方案之业务设计流程

供应链需求调研CheckList

企业应用之性能实时度量系统演变

如有想了解更多软件设计与架构, 系统IT,企业信息化, 团队管理 资讯,请关注我的微信订阅号:

作者:Petter Liu

出处:http://www.cnblogs.com/wintersun/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。 该文章也同时发布在我的独立博客中-Petter Liu Blog。