人工智能用于网络安全的「能」与「不能」

作者:佚名 2017-08-07 10:17:06

移动开发

人工智能 瑞星发布的《2017 年上半年中国网络安全报告》显示,2017 年 1-6 月,瑞星「云安全」系统共截获病毒样本总量 3,132 万个,病毒感染次数 23.4 亿次,病毒总体数量比 2016 年同期上涨 35.47%。逐渐上涨的病毒数量让网络安全受到了前所未有的关注,以人工智能驱动的网络安全公司也受到了资本的青睐。

若说过去几个月,最让网民惊魂未定的是什么,非以下这些病毒攻击莫属。

7 月,CopyCat 病毒使 1400 万部安卓手机遭殃;

6 月,Petya 病毒感染全球 60 多个国家;

5 月,WannaCry 病毒来势汹汹,席卷全球,至少 150 个国家受到攻击。

然而,在安全厂商瑞星根据病毒感染人数、变种数量和代表性评选的「2017 年上半年病毒 Top10」中,令人胆颤心惊的 WannaCry 病毒却只能排列第九。

瑞星发布的《2017 年上半年中国网络安全报告》显示,2017 年 1-6 月,瑞星「云安全」系统共截获病毒样本总量 3,132 万个,病毒感染次数 23.4 亿次,病毒总体数量比 2016 年同期上涨 35.47%。

逐渐上涨的病毒数量让网络安全受到了前所未有的关注,以人工智能驱动的网络安全公司也受到了资本的青睐。单就 6 月份,就至少有 7 家将人工智能用于网络安全的公司获得新一轮融资,而融资总额接近 5 亿美元。

网络安全面临严峻考验

「2016 年全球互联网用户达到 35 亿人,约占世界总人口的一半。到 2020 年,接入互联网的终端设备预计将达到 120 亿台。」这是来自国际电信联盟于 2017 年 7 月发布的《全球网络安全指数》中的数据。

而随着智能设备的广泛应用,大规模普及的物联网必将为攻击者提供大量新机会,工作与生活的界限愈加模糊,一台联网设备,只要被攻陷,从银行等财务信息到健康等个人信息,则可能全部泄露。而在互联时代,只要攻克一台设备,其他设备就可能瞬间被瓦解。

这样的事情已有先例。2016 年 10 月,一款名为 Mirai 的恶意软件侵袭了大量存在漏洞的智能摄像头、智能网关、智能家电等物联网设备,被感染后的它们瞬间变成了网络中的「肉鸡」设备。在工控领域,2010 年的 Stuxnet 蠕虫病毒能够针对西门子的监控与数据采集(SCADA)系统进行攻击,并通过 U 盘和局域网进行传播。

万物互联,内网和外网的边界逐渐模糊,网络泛化则成为大趋势,比如特斯拉的汽车在各种场合都可以接入 wifi,还可以接入 3G/4G 网络,而在未来的交通中,无人驾驶车还将与交通灯、交通台,甚至是和其他车互通互联——这意味着更多的潜在攻击点。

「一旦入网,有很多传统的攻击手段就能像攻击电脑一样攻击无人驾驶车,WannaCry 病毒同样可以入侵车,这造成的问题将会更大。」德国弗劳恩霍夫应用集成信息安全研究所认知信息安全研究组组长肖煌在接受机器之能的采访时说。

这表明,无论是现在,还是将来,网络安全将面临着严峻的考验。随着人工智能被应用于各个垂直领域,网络安全面临的新的挑战,也为人工智能的大展身手带来了重要的契机。

在这个新兴领域,巨头已经出现。用人工智能预测网络攻击的 Cylance 公司是估值 10 亿美元以上的独角兽,其人工智能反病毒软件「Cylance PROTECT」可以预测威胁的发生。该公司曾在去年演示了一项技术,在没有网络连接的情况下,仅需 60 MB 内存和 1% 的 CPU 就能保护计算机免受攻击。

人工智能于网络安全:异常检测和提升效率

在网络安全领域,对威胁的识别,并非一蹴而就,而是渐进发展的过程。亚信网络安全产业技术研究院副院长童宁在 7 月初举办的 C3 安全峰会上介绍,安全厂商起初通过黑白名单技术,将目标进行好/坏定性,用这样的一维特征来识别威胁。随后是匹配字符串这样的二维特征,如果请求里包含某一类型的数据,就会被认定为非法。在这之后是多维特征,要辨别一个程序是好是坏,先让它运行,再监督它的运行过程,将运行过程中的信息形成多维特征,用于判断。但多维特征技术的致命缺点就是开销太大,效率低下,因此无法达到客户要求。

在 2000 年以后,随着移动互联网的发展,有大量设备产生各式各样的日志,因此在日志管理和分析方面,有了长足的发展。而包括关联分析等机器学习算法也被大量使用。

在机器学习中,童宁表示,监督学习则是一个高效的多维度特征发现方法,适用于恶意程序、勒索病毒以及垃圾邮件的防治。但监督学习也面临着挑战:一,模型的新鲜度,因为威胁每天都在变化,而监督学习并不是每天都在学习,如果不每天学习,最新的威胁就识别不出来。二,模型的准确率,学习是一回事,但真正使用时的精度又是另一回事。三,模型的召回率,也就是说漏掉了多少威胁,有多少威胁没有抓住。

因此,监督学习并不是万能的,比如反欺诈、态势感知、用户行为分析则更适合无监督学习。然而,无监督学习也面临着另外的挑战,因为无监督学习一般是在客户的网络环境中进行,因而很有可能面临投毒攻击。

「机器学习技术的优势是它的多维识别能力,然而机器学习技术再强大也需要与其他手段综合起来利用,效果才更好。」童宁说。

肖煌同样指出,将机器学习用于网络安全,在很多场景,预测精度并不能达到他们要求的 0.000001 的误报标准。从这个角度来说,人工智能也只是辅助手段,还需要与传统手段结合。

然而,肖煌认为,将人工智能用于网络安全则有另外的优势,那就是提高分析效率。人工智能的典型作用是代替人类做大量重复的劳动,比如用人工智能分析影像图片,将影像医生从低效率的重复劳动中解放了出来。

网络安全行业,也同样如此。

数据显示,中国目前对网络安全人才的总需求量超过 70 万,每年增加的人才却不过两三万,缺口高达 95%。而且,一个分析师每天能分析的漏洞却是非常有限的。

「如果不通过自动化的手段,将来物联网连接设备数爆发的时候,大量的信息安全隐患只依赖人来分析是不太可能的。」肖煌表示,一个信息安全分析师每天最多能看一两千条 log 数据,或者一两百个代码片,而对人工智能来说,几百万条数据,只需花费几分钟时间。

根据肖煌的观察,信息安全和人工智能,领域不同,思维方式也有一定区别,前者更偏向于系统工程,后者则更偏向于数学思维。因此,肖煌的很多同事认为人工智能解决的问题有限,更愿意使用传统的方法,但也会朝着分析自动化的方向思考。

「我相信任何一个做信息安全的人必然要向这个方向靠拢。」肖煌希望能用趋于成熟的自动化手段完成垂直领域的性能提升,包括分析的效率、时效性、规模和可解释性。

人工智能时代的攻与防

网络安全是道高一尺魔高一丈的世界。安全人员使用人工智能技术阻挡黑客攻击,反过来这也会使黑客使用人工智能技术发起更复杂的攻击。而随着大量人工智能模型开源,黑客入侵的工具也愈发多样化。

肖煌表示,只要稍加学习,黑客就可以利用开源工具欺骗识别系统,而技术难度的降低会促使很多人成为黑客,或者是进行一些此前做不到的攻击。

这并非杞人忧天。

在网络钓鱼电子邮件中已有这样的案例,黑客通过模仿人类的说话习惯和内容,使得企业或个人被入侵时更加难以识别。

肖煌认为,以后的病毒变种会越来越多,检测越来越难,规模越来越大,生成的时间越来越短。

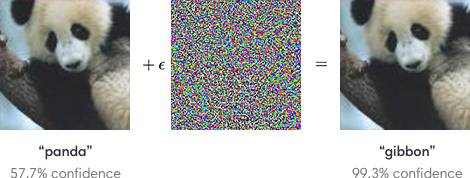

叠加在典型图片输入上的对抗输入会让分类器产生错觉,误将熊猫识别为长臂猿

2017 年 2 月,OpenAI 在发表的最新研究中,指出人工智能安全领域的另一大隐忧:对抗样本。在图像识别问题中,攻击者将对抗样本输入机器学习模型,让机器在视觉上产生幻觉,从而让系统产生误判。而在论文《解释并驯服对抗样本》(Explaining and Harnessing Adversarial Examples)中有一个例子:一张熊猫图片,被加入人为设计的微小噪声后,就导致系统将熊猫识别为长臂猿。

多年来,肖煌一直在研究对抗性机器学习,致力于攻克机器学习算法本身的缺陷。他分析道,依赖于数据的机器学习算法、深度学习算法本身存在很大的缺陷。对抗性生成网络,则利用这种缺陷,设计新的架构去生成模型。

「因为目前的机器学习严重依赖于数据的分布,如果数据分布本身很复杂,或者是人为地把它变得复杂,黑客如果有手段去生成恶意的样本,就会导致识别不出来,或者识别错误。」肖煌进一步解释。

肖煌表示,如果干扰被用在无人驾驶领域,后果则不堪设想。比如,在无人驾驶测试路段德国 A9 高速公路上,有专门的标识引导无人驾驶车。如果路边的标识被恶意修改,误导依赖标识的无人驾驶车,则会造成极度危险的情况。

肖煌认为,因为算法本身的缺陷,在大规模使用人工智能之后,网络安全则需要更换思路,设计新的方法。

对此,他提供了以下路径:

一,增加分析端的可解释性。肖煌分析,如果是病毒威胁入侵,用机器学习检测的方法,很难解决,因此希望能在信息安全泄露事故时,用统计学的方法理解其中的关联,黑客如何入侵系统,攻击的路径是什么,又是哪个环节出现了问题,找出这些关联,或者从因果关系图谱角度进行分析,从而增加分析端的可解释性。

二,目前的机器学习算法模型太复杂,需要使用大量的数据,就存在 Tradeoff(权衡取舍)的情况。肖煌认为,降低算法复杂度的方法有很多,比如,引入先验的知识,引导模型往一个方向学习。这样学习的模型复杂度会降低,需要的数据也比较少。

三,信息安全情报的共享也非常重要。比如,模型存在某个缺陷,把这个缺陷提取出来,用一种高效的手段,编译到另一种模型中去,另外的模型则无此缺陷。肖煌认为,这类似迁移学习(Transfer learning),只是迁移学习是迁移中间的学习结果,实际上中间学习出来的异常也可以迁移,从而增加算法的安全性。

声明:本文由机器之能(微信公众号:almosthuman2017)原创出品。